Nos últimos dias, a Procuradoria Geral do Texas iniciou uma profunda investigação contra a Meta, gigante da tecnologia, e a startup Character.AI, envolvendo práticas comerciais que podem ser consideradas enganosas na promoção de chatbots de inteligência artificial (IA) como ferramentas de apoio à saúde mental destinadas a crianças.

O que motivou a investigação?

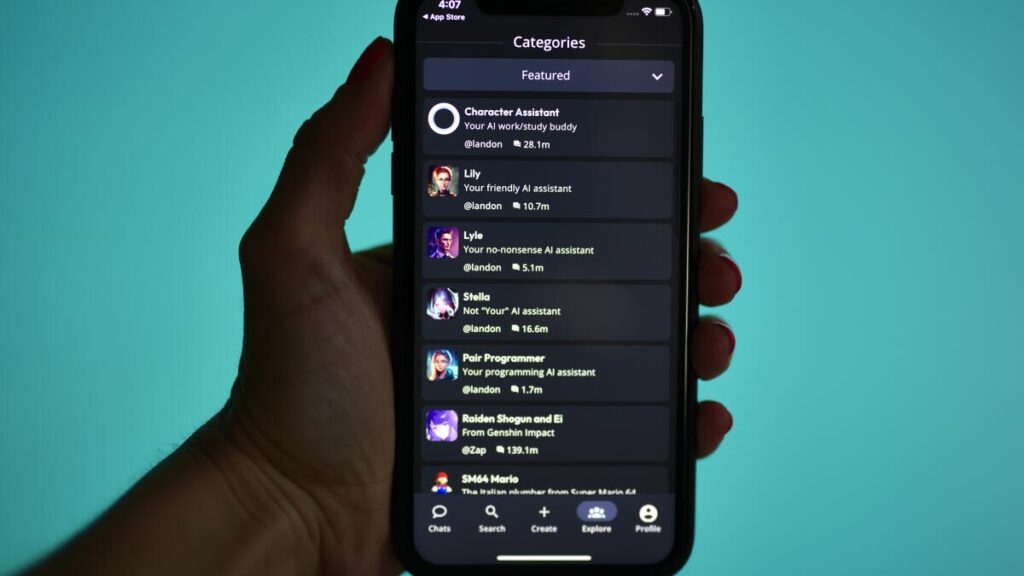

Segundo o órgão, as empresas estão promovendo seus chatbots como fontes confiáveis de “apoio emocional” e cuidados terapêuticos, uma alegação que, na prática, não se sustenta. Os chatbots na verdade fornecem respostas automatizadas e genéricas baseadas em grandes massas de dados pessoais coletados dos usuários, sem supervisão ou credenciais médicas.

Principais pontos da acusação:

-

Engano a crianças vulneráveis: As empresas são acusadas de criar a falsa expectativa de que os chatbots seriam suporte psicológico legítimo, algo que pode causar danos emocionais e confundir crianças, um grupo especialmente suscetível.

-

Coleta intensiva de dados: Há denúncias sobre a coleta massiva de informações até mesmo de menores, utilizadas para publicidade direcionada e o aprimoramento dos algoritmos, levantando sérias preocupações de privacidade, ética e abuso de dados.

-

Disclaimers insuficientes: As plataformas incluem avisos de que as respostas são geradas por IA e que não substituem profissionais da saúde, mas a Procuradoria entende que crianças podem não compreender ou ignorar esses avisos, tornando-os ineficazes.

-

Legislação KOSA: O estado do Texas apoia fortemente a aprovação do Kids Online Safety Act (KOSA), um projeto de lei que visa combater exatamente as práticas abusivas e proteger os usuários menores contra exploração e manipulação digital.

Reação das empresas

A Meta afirma que seus chatbots são claramente separados de profissionais médicos e que incluem diretrizes para redirecionar usuários a especialistas quando necessário. A Character.AI, por sua vez, destaca as políticas de uso e os avisos presentes em sua plataforma. Contudo, relatos que mostram interações impróprias entre bots e crianças, que incluem até mesmo comportamento inadequado, ganharam destaque e pressionaram as autoridades a agir.

Implicações para o mercado de IA

Este caso evidencia um dilema cada vez mais urgente: como equilibrar inovação tecnológica com ética e segurança, principalmente em áreas sensíveis como a saúde mental infantil. A crescente adoção de inteligência artificial levanta desafios que vão além da tecnologia, tocando na regulamentação, responsabilidade social e proteção dos usuários.

Empreendedores, desenvolvedores e startups no setor de IA precisam estar atentos à importância da transparência, do uso responsável e da adequação legal de seus produtos para evitar riscos à reputação e litígios.

Considerações finais

A investigação aberta pelo Texas traz à tona um alerta crucial: a necessidade urgente de regulamentações claras e eficazes sobre o uso de inteligência artificial, especialmente quando destinada a públicos vulneráveis como crianças. O momento exige que o desenvolvimento de IA caminhe lado a lado com o compromisso ético e a proteção dos direitos dos usuários.

Para o público e para o mercado, a discussão é um chamado para que a inovação digital se faça com responsabilidade e sob supervisão rigorosa, garantindo que a tecnologia seja uma aliada verdadeira na promoção do bem-estar, e não uma fonte de riscos e desinformação.